KI in der Verifikation

Künstliche Intelligenz hat sich als leistungsfähiges Werkzeug für die Analyse großer Datenmengen erwiesen, was sie zu einem wichtigen Faktor für künftige Rüstungskontrollverifikationsregime macht. Dieses Kapitel befasst sich mit den möglichen Folgen von KI für die Verifikation. Wir stellen fest, dass die Verfügbarkeit geeigneter Trainingsdaten zu Verifikationszwecken eine Herausforderung darstellen kann, die von KI-Techniker*innen, die Modelle für die Verifikation erstellen, gelöst werden muss. Die Erklärungsfähigkeit („Explainability“) von KI-Ergebnissen – d. h. die Begründung hinter den Ergebnissen – muss von Entwickler*innen und Anwender*innen berücksichtigt werden, um solide Verifikationsbewertungen zu gewährleisten und den Inspektor*innen Einblicke in das Potenzial und die Grenzen von entscheidungsunterstützenden KI-Modellen zu geben. Um Vertrauen und Akzeptanz für KI-gestützte Verifikation und Überwachung zu schaffen, sollten KI-Verifikationssysteme gemeinsam mit allen Vertragsparteien entwickelt und getestet werden. Trainingsdaten und Modelle sollten nach Möglichkeit von allen Beteiligten geteilt werden, um die Transparenz zu fördern und eine unabhängige Validierung zu ermöglichen.

In den letzten Jahren ist die Menge an Daten, die für die Verifikation von Nichtverbreitungs- und Rüstungskontrollverpflichtungen sowie für die Überwachung einschlägiger Aktivitäten zur Verfügung stehen, kontinuierlich gestiegen. Dies betrifft zum einen Datenquellen, die bereits heute für solche Zwecke genutzt werden. Es ist eine Zunahme der Verwendung verschiedener Messsensoren zu beobachten, insbesondere für neuartige Fernüberwachungsanwendungen. Die Internationale AtomenergieOrganisation (IAEO) betreibt beispielsweise mehr als 1.300 Beobachtungskameras, die dazu beitragen, die Zahl der Inspektionen vor Ort zu verringern und gleichzeitig das Wissen über den Verbleib des nuklearen Materials aufrechtzuerhalten.1 Die Organisation des Vertrags über ein umfassendes Verbot von Nuklearversuchen (CTBTO) betreibt Überwachungsstationen auf der ganzen Welt, um verbotene Atomwaffentests aufzudecken. Daten, wie z. B. seismische oder Radionuklid-Messungen, werden von 321 Stationen kontinuierlich aufgezeichnet, und die Datenströme werden ständig ausgewertet.2 Außerdem können kommerzielle Satelliten mindestens alle paar Stunden jeden beliebigen Punkt auf der Erde abbilden.3 Andererseits stellt sich die Frage, inwieweit die überwältigende Menge an öffentlich zugänglichen Informationen – auch aus den sozialen Medien – in Zukunft zu Verifikations- und Überwachungszwecken genutzt werden könnte. Dazu gehören heterogene Daten wie Text, Bilder, Audio und Video.

Die Analyse der wachsenden Datenmengen, die in den heutigen Verifikations- und Überwachungskontexten verwendet werden, ist angesichts der begrenzten Anzahl von Inspektor*innen und Analyst*innen bereits eine anspruchsvolle Aufgabe. Die Ausweitung der Datenmenge, die für die Verifikation und Überwachung verwendet wird, erfordert daher computergestützte Unterstützung. Dies ist insbesondere dann der Fall, wenn die Daten heterogen, unstrukturiert und komplex sind. Dieses Kapitel befasst sich mit KI als Werkzeug für die Analyse von Daten im Kontext von internationaler Sicherheit und Frieden. Kann sie ein zuverlässiges und vertrauenswürdiges Verifikations- und Überwachungsinstrument werden?

KI wird wahrscheinlich für mehrere Bereiche der Rüstungskontrolle relevant werden.4 Verschiedene Bereiche nutzen gemeinsame Datenquellen, wie z. B. Satellitenbilder, und haben ähnliche Herausforderungen bei der Datenanalyse. Neben den derzeitigen vertraglichen Verifikationsregimen können KI-Anwendungen auch in weiteren Bereichen wie der Überwachung von Waffenstillständen, friedenssichernden Maßnahmen oder der gesellschaftlichen Verifikation mittels Daten aus öffentlich zugänglichen Quellen von Bedeutung sein. In der Tat stammen einige der ersten KI-Anwendungen aus diesen Bereichen.

Verifikationsrelevante Daten

Daten können sowohl mit der als auch ohne die Absicht erzeugt werden, sie zur Verifikation zu verwenden. Instrumentengestützte Daten – wie z. B. technische Messoder Überwachungsdaten – wurden schon immer für Inspektionen verwendet, aber Umfang und Volumen solcher Daten haben mit der Einführung von neuen Fernüberwachungsansätzen zugenommen. Solche Daten dienen in erster Linie dazu, die Einhaltung von Rüstungskontrollverpflichtungen zu bewerten. Die Erfassung von Messdaten kann in Laboratorien und anderen kontrollierten Umgebungen getestet und angepasst werden, und Messgeräte können für diesen Zweck entworfen und geeicht werden.

Andererseits sind in letzter Zeit immer mehr Daten aus öffentlich zugänglichen Quellen über eine Reihe von Medien verfügbar geworden. Obwohl der Zweck dieser Daten ursprünglich nicht mit der Verifikation zusammenhängt, können sie dennoch für diesen Zweck nützliche Informationen enthalten. Die Daten, in der Regel in Form von Text-, Bild-, Audio- und Videodateien, sind oft im Internet frei zugänglich – z. B. in Form von Beiträgen in sozialen Medien – oder müssen digitalisiert werden – z. B. Zeitungsartikel oder Radioübertragungen. Da diese Daten fast überall auf der Welt produziert werden, können sie für Verifikation relevant sein, da sie nicht deklarierte Anlagen oder Aktivitäten aufdecken können. Die Daten sind zwar leicht verfügbar, aber unstrukturiert, und die Herkunft der Daten stellt die Analyse vor mehrere Herausforderungen, z. B. unterschiedliche Sprachen und Datenformate, außergewöhnlich große Mengen und begrenzte Möglichkeiten zur Überprüfung der Glaubwürdigkeit.

Es muss betont werden, dass derzeit nicht bekannt ist, wie relevant öffentlich zugängliche Informationen für Verifikationszwecke sind. Umfassende Überprüfungen dieser Daten könnten als exzessiv angesehen werden und Fragen der Verhältnismäßigkeit aufwerfen. Sie würden höchstwahrscheinlich nicht als Grundlage für die Beurteilung der Einhaltung von Verpflichtungen akzeptiert werden, sondern eher für weniger formale Überwachungszwecke. Ihr Zweck könnte darin bestehen, Hinweise zu erhalten, die dann formale Verifikationsaktivitäten auslösen könnten, z. B. indem sie dabei helfen, zu bestimmen, wann und wo Vor-Ort-Inspektionen durchgeführt werden sollen. Wenn sie wirksam sind, könnten solche Verfahren möglicherweise die Zahl der Inspektionen vor Ort reduzieren

KI-gestütze Datenanalyse

KI ist besonders geeignet, um mit großen und vielfältigen Datensätzen umzugehen, und kann Muster und Zusammenhänge erkennen. Es gibt mehrere KI-basierte Analysen, die an Verifikations- oder Überwachungsaktivitäten angepasst werden könnten. So gibt es beispielsweise Ansätze, bei denen KI verwendet wird, um Beiträge in sozialen Medien in Krisenszenarien zu gruppieren und zu kennzeichnen,5 die angepasst werden könnten, um Waffenstillstandsverletzungen zu identifizieren oder steigende Spannungen und bevorstehende Zusammenstöße zwischen bewaffneten Gruppen zu erkennen. In einer Studie im nuklearen Bereich wurde die Fähigkeit von KI-Systemen, verschiedene Formen von Daten gleichzeitig zu analysieren, genutzt, um Texte, Bilder, Audio- und Videodateien zu scannen, mit dem Ziel die Weiterverbreitung von Nukleartechnik zu ermitteln, indem die KI abgefragt wurde, Daten im Zusammenhang mit Geräten zur Urananreicherung zu identifizieren.6 Eine andere Studie entwickelte eine vor Ort einsetzbare KI zur Identifizierung chemischer Kampfstoffe mit kolorimetrischen Sensoren.7 Weitere KI-Anwendungen für die Verifikation werden im Anhang zu diesem Kapitel beschrieben.

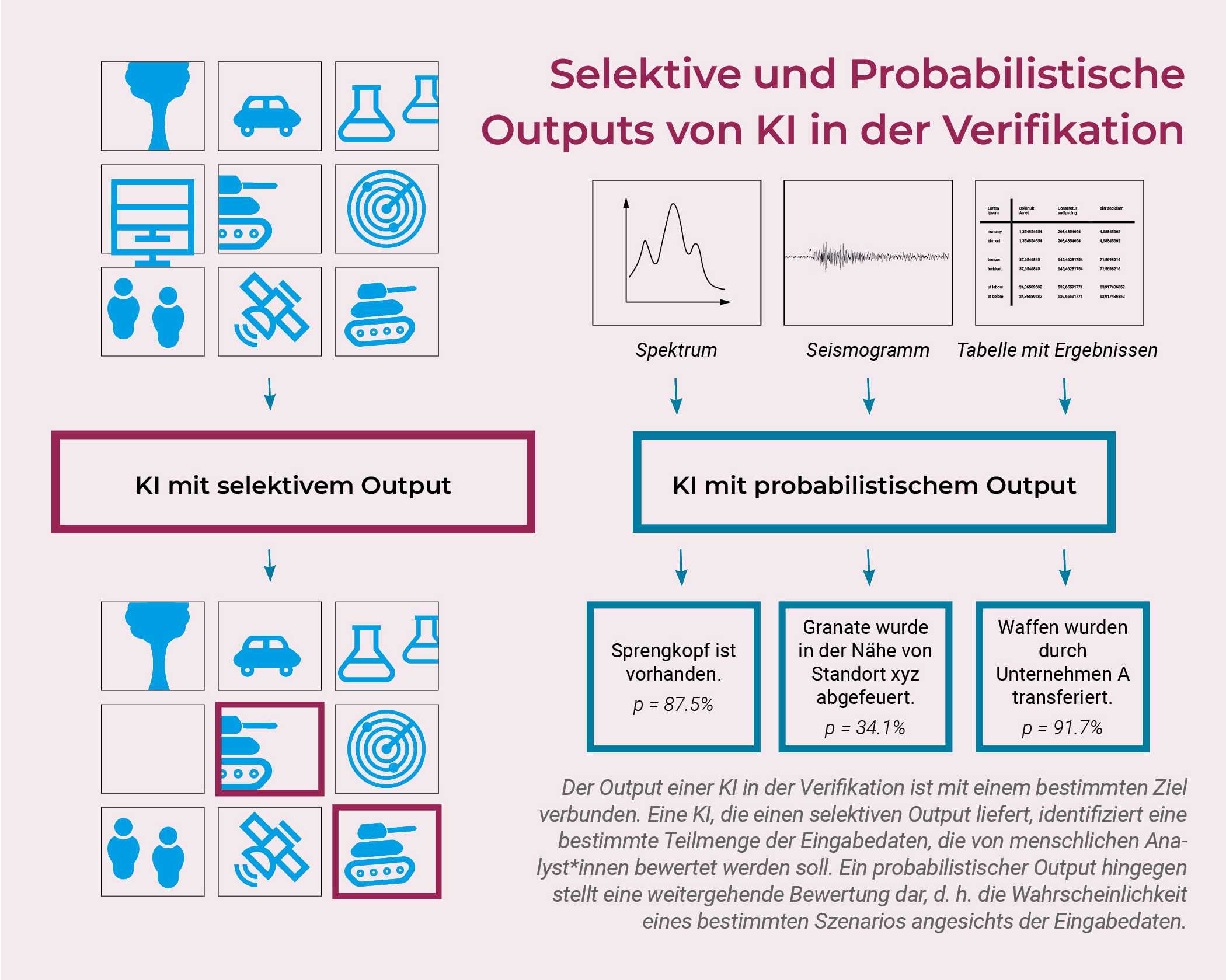

Als Werkzeug der Verifikation muss der Output einer implementierten KI mit einem eindeutigem Verifikationsziel verknüpft sein. Wir unterscheiden zwischen selektiven und probabilistischen Outputs von KI-Anwendungen. Ein selektiver Output ist idealerweise eine bestimmte Teilmenge der Eingabedaten, die verifikationsrelevante Informationen enthalten könnte, wie z. B. Indikatoren für die Nichteinhaltung von Verpflichtungen. Menschliche Analyst*innen müssen die tatsächliche Bedeutung der identifizierten Daten überprüfen und bewerten. Es ist nicht vertretbar, dass die KI endgültige Schlussfolgerungen zieht, sondern sie sollte stattdessen menschlichen Inspektor*innen dabei helfen, sich auf die konkreten Daten zu konzentrieren, die ihre Bewertungen beeinflussen. Eine KI könnte zum Beispiel Bilder identifizieren, die vertraglich verbotene Gegenstände zeigen, oder verdächtige Aktivitäten hervorheben. Im Zusammenhang mit Sensordaten ist ein probabilistischer Output eine direkte Bewertung, d. h. eine abgeleitete Größe. Die betreffende KI könnte z. B. den Ort bestimmen, von dem aus eine Granate während eines Waffenstillstands abgefeuert wurde, oder die Wahrscheinlichkeit, dass ein bestimmter Vorgang stattfindet. In diesen Fällen übernimmt die KI eine direktere Rolle beim Ziehen von Schlussfolgerungen.

Herausforderungen

Trainingsdaten

Eine wichtige Herausforderung sind die Trainingsdaten für die KI. Die Qualität, Vielfalt und Unvoreingenommenheit des Trainingsdatensatzes ist ein entscheidender Faktor für die Qualität des Modells. Im Allgemeinen müssen die Trainingsdatensätze hinreichend groß sein und genügend Daten enthalten, die den zu erwartenden realen Szenarien unter Beobachtung ähnlich sind. Wenn eine KI beispielsweise die Aufgabe hat, Bilder von verschiedenen Waffen zu erkennen, sollte die Trainingsmenge unterschiedliche Bilder enthalten – z. B. verschiedene Winkel, Beleuchtungen, Hintergründe und unvollständige oder veränderte Objekte. Die Beschaffung dieser Art von Daten kann ein mühsames Unterfangen sein und wird sogar noch schwieriger, wenn ständig aktualisierte Datensätze erforderlich sind, um sich an dynamische Entwicklungen anzupassen. Die erforderlichen Daten können spärlich oder gar nicht vorhanden sein. Es ist möglich, die Größe des Datensatzes zu erhöhen, indem man bestehende Daten ergänzt8 oder Datensätze mit synthetischen, computergenerierten Daten erstellt. Ein auf solchen Daten trainiertes Modell könnte unter Umständen jedoch nicht robust sein, d. h. bei der Anwendung auf reale Daten schlecht abschneiden. Sowohl reale als auch computergenerierte Trainingsdaten können mit inhärenten Verzerrungen behaftet sein, die von KI-Modellen bei ihrem Training übernommen werden können.

Eine weitere Herausforderung, die vor allem mit menschlichen Kommunikationsdaten verbunden ist, sind die nicht gekennzeichneten Daten. Diese bestehen aus Inputs ohne begleitende Beschreibungen oder Klassifizierungen, was es für die KI schwieriger macht, zu lernen, was die einzelnen Inputs darstellen. Bilder in sozialen Medien enthalten beispielsweise in der Regel keine Beschriftung dessen, was auf dem Bild zu sehen ist. Die manuelle Beschriftung dieser Daten kann fehleranfällig und mühsam sein, so dass technische Ansätze genutzt werden müssen, wie z. B. die Verwendung eines kleinen manuell beschrifteten Datensatzes zur „Feinabstimmung“ eines Modells, das bereits für eine ähnliche Aufgabe trainiert wurde, d. h. „Transfer-Lernen“ („Transfer Learning“).9 All diese Mittel zur Bewältigung der Herausforderungen von Trainingsdatensätzen können zu unerwarteten KI-Ergebnissen führen, wenn sie auf reale Daten angewendet werden. Daher ist die Validierung von KI-Ergebnissen mit realen Daten ein wichtiger Teil des Entwicklungsprozess.

Vertrauen und Erklärungsfähigkeit

Die Erklärungsfähigkeit („Explainability“) von KI-Ergebnissen ist ein allgemeines Thema, aber besonders wichtig bei der Verifikation. Im Gegensatz zu „traditionellen“ Analysetechniken führen KI-Modelle Berechnungen mit Millionen von fein abgestimmten Parametern durch, was es schwierig oder unmöglich macht, zu verstehen, welche Datenmerkmale für die Ermittlung der Ergebnisse am wichtigsten waren. Kann man z. B. sicher sein, dass die ausgewählten Daten, die den Analyst*innen gezeigt werden, repräsentativ sind? Können wir sicher sein, dass keine Daten herausgefiltert werden, die Gegenindikationen liefern könnten? In einem Verifikationsszenario, insbesondere in Fällen mutmaßlicher Verstöße, ist es unerlässlich, erklären zu können, wie die Inspektor*innen zu ihren endgültigen Schlussfolgerungen kommen. Im Kontext formeller Rüstungskontrolle muss gegenseitiges Vertrauen in die Gültigkeit der Ergebnisse der KI bestehen, bevor sie in ein Verifikationsregime aufgenommen werden kann. Selbst in einem informellen Rahmen hängt die internationale Akzeptanz von Bewertungen, die KI-Modelle beinhalten, vom Vertrauen in die Zuverlässigkeit der KI ab.

Es gibt mehrere Strategien, dieses Problem anzugehen. Erstens sollten Ansätze der erklärungsfähigen KI („XAI“) genutzt werden, um etwas Licht in die „Black Box“ der KI zu bringen. Der Bereich der XAI ist in den letzten Jahren erheblich gewachsen, und es wurden Techniken wie die „Attribution“ entwickelt, die die wichtigsten Aspekte der Inputdaten für den Output der KI hervorheben.10 Dennoch gibt es in diesem Bereich noch viele offene Forschungsfragen. Bis heute kann die XAI nicht alle Fragen der Erklärungsfähigkeit beantworten.

Zweitens muss die Forschung und Entwicklung von KI, insbesondere von Modellen und Trainingsdaten, für alle Parteien so transparent wie möglich sein, um das Vertrauen in die Ergebnisse der KI zu fördern und damit die notwendige Grundlage dafür zu schaffen, dass KI in internationalen Abkommen akzeptiert wird. Verifikationsregime würden kodifizierte Verfahren für die Datenerfassung, die Auswahl von Trainingsdaten, die Entwicklung von KI-Modellen und deren Training, Tests und Validierung erfordern. Um das nötige Vertrauen aller Beteiligten in die KI-Modelle zu schaffen, ist generell ein hohes Maß an Transparenz erforderlich. Im besten Fall bedeutet dies das Teilen von Trainingsdaten und -modellen sowie die gemeinsame internationale Entwicklung von KI in allen Phasen. Außerdem müssen Erkenntnisse über Unzulänglichkeiten und Grenzen des Modells und mögliche Fehler offengelegt werden. Wenn dies nicht gewährleistet ist, können die Ergebnisse der KI von den Parteien abgelehnt werden, oder es könnte die KI sogar zu einer ausnutzbaren Schwachstelle werden, die es den Parteien ermöglicht, die Zuverlässigkeit des Verifikationsregimes per se in Frage zu stellen.

Einige Interessengruppen könnten jedoch Vorbehalte gegen eine umfassende Transparenz äußern. Staaten können sich weigern, Daten weiterzugeben, die als sensibel oder relevant für Dual Use erachtet werden. Völlig transparente KI-Modelle könnten adversarial attacks ermöglichen – subtile, kaum fassbare Änderungen der Inputdaten, mit denen das Modell getäuscht werden kann. Die Bedenken hinsichtlich der Vertraulichkeit und Integrität von KI-Modellen müssen erörtert werden, bevor KI als Teil von Verifikationsregimen betrachtet wird. Nichtsdestotrotz darf jede Lösung, die aus einer solchen Diskussion hervorgeht, die Maxime einer weitreichenden Transparenz nicht außer Acht lassen – andernfalls ist es unwahrscheinlich, dass KI als akzeptierte und vertrauenswürdige Technik zur Verifikation angesehen wird.

Menschen und Maschinen in Entscheidungsprozessen

Die Einführung von KI in Verifikationsprozesse führt unweigerlich dazu, dass Teile der Entscheidungsfindung an das KI-System abgegeben werden, auch wenn die KI die Inspektor*innen lediglich unterstützt, die weiterhin ihre eigenen Schlussfolgerungen ziehen. Menschliche Analyst*innen haben nur begrenzte Kontrolle über die Berechnungen und Überlegungen der KI, die jedoch Informationen produziert, auf die sich die Analyst*innen verlassen. Dies gilt sowohl für probabilistische als auch für selektive Outputs, bei denen die Analyst*innen nur einen Teil der Daten sehen, der möglicherweise verzerrt ist. Allen KI-Ansätzen gemeinsam ist, dass die endgültige Bewertung durch den Menschen nicht auf dem vollständigen Originaldatensatz basiert, der der KI vorgelegt wird, sondern auf einem aufbereiteten und gefilterten.

Um KI verantwortungsvoll und verantwortungsbewusst zur Verifikation einsetzen zu können, müssen Fragen über die Rolle von und die Interaktion zwischen Menschen und Maschinen diskutiert werden. Zum Beispiel gibt es bereits einen Diskurs über ethische KI-Richtlinien für Anwendungen in IAEO-Sicherungsmaßnahmen.11 Auch wenn der Mensch die endgültige Entscheidung trifft, ist das Vertrauen in die entscheidungsunterstützende KI im Allgemeinen ein zentrales Thema.12 Wenn Menschen Daten direkt überprüfen oder analysieren, können sie von der Expert*innenintuition und kontextbezogenen Erkenntnissen profitieren. Wenn KI den Schritt der Datenverarbeitung übernimmt, sind diese „weichen” Urteilsfähigkeiten nur schwer aufrecht zu erhalten.

Schlussfolgerungen

KI-Techniken werden sehr wahrscheinlich eine Rolle bei der zukünftigen Verifikation und Überwachung spielen. Die Menge der verfügbaren Daten steigt rapide an und wurde bereits in anderen Zusammenhängen erfolgreich mit KI analysiert, was KI zu einem unverzichtbaren Werkzeug macht. Das Vertrauen in die KI-Werkzeuge, die bei Verifikation eingesetzt werden, ist von entscheidender Bedeutung, denn das Ziel von Verifikation ist es, Rückschlüsse auf die Einhaltung der Vorschriften zu ziehen, und das ist nicht nur ein technischer, sondern auch ein politischer Prozess. Dies ist besonders wichtig, da der Einsatz von KI bei Verifikation zwangsläufig bedeutet, dass die Inspektor*innen weniger unabhängige Kontrolle haben.

Ansätze, um damit umzugehen und Vertrauen in KI-Methoden aufzubauen, sind technischer und prozeduraler Natur. Auf der technischen Seite können XAI-Techniken angewendet werden, die bis zu einem gewissen Grad erklären können, wie die Inputs zu einer bestimmten Bewertung geführt haben. Verfahrenstechnisch muss KI für Verifikation auf transparente Weise geplant, entwickelt und getestet werden, um Vertrauen in die Ergebnisse der KI zu schaffen, vorzugsweise in internationalen Feldübungen mit echten Daten zur Validierung. Gleichzeitig ist ein Dialog über den Umgang mit sensiblen Daten und die Gewährleistung der Modellintegrität notwendig, um Offenheit für umfassende Transparenz zu ermöglichen. Diese Debatte muss gemeinsam geführt werden, unter Einbeziehung aller Beteiligten und vor der Einbettung von KI in ein Verifikationsregime.

Die Beteiligten sollten jetzt Ressourcen bereitstellen, da sich KI-Fähigkeiten schnell weiterentwickeln und der Aufbau eines ausreichenden Vertrauens in die KI-Technologie über einen langen Zeitraum hinweg erhebliche Anstrengungen erfordern wird. Da es schwierig sein kann, den Rückstand aufzuholen, müssen sich Staaten, die künftige internationale Sicherheitsabkommen mitgestalten wollen, frühzeitig engagieren.

- IAEA. (2023). IAEA Annual Report 2023. https://www.iaea.org/sites/default/files/gc/gc68-2.pdf; Smartt, H. (2022). Remote Monitoring Systems/Remote Data Transmission for International Nuclear Safeguards. Sandia National Laboratories (SNL). https://doi.org/10.2172/1862624 ↩

- CTBTO. (n.d.). International Data Centre. Abgerufen am 31. Juli, 2025, unter https://www.ctbto.org/our-work/internationaldata-centre; CTBTO. (n.d.). The International Monitoring System. Abgerufen am 31. Juli 2025, unter https://www.ctbto.org/our-work/international-monitoring-system ↩

- Moric, I. (2022). Capabilities of Commercial Satellite Earth Observation Systems and Applications for Nuclear Verification and Monitoring. Science & Global Security, 30(1), 22–49. doi:10.1080/08929882.2022.2063334 ↩

- Reinhold, T., & Schörnig, N. (Hrsg.). (2024). Armament, Arms Control and Artificial Intelligence. Springer Verlag. https://doi.org/10.1007/978-3-031-11043-6 ↩

- Bayer, M., Kaufhold, M.-A., & Reuter, C. (2021). Information Overload in Crisis Management: Bilingual Evaluation of Embedding Models for Clustering Social Media Posts in Emergencies. ECIS 2021 Research Papers.; PEASEC. (n.d.). Open Data Observatory. Abgerufen am 27. Mai 2025, unter https://peasec.de/projects/observatory/ ↩

- Feldman, Y., Arno, M., Carrano, C., Ng, B., & Chen, B. (2018). Toward a Multimodal-Deep Learning Retrieval System for Monitoring Nuclear Proliferation Activities. Journal of Nuclear Materials Management, 46(3). https://www.ingentaconnect.com/content/inmm/jnmm/2018/00000046/00000003/art00008 ↩

- Bae, S., Kang, K., Kim, Y. K., Jang, Y. J., & Lee, D.-H. (2025). Field-Deployable Real-Time AI System for Chemical Warfare Agent Detection Using YOLOv8 and Colorimetric Sensors. Chemometrics and Intelligent Laboratory Systems, 261, 105365. https://doi.org/10.1016/j.chemolab.2025.105365 ↩

- Shorten, C., & Khoshgoftaar, T. M. (2019). A Survey on Image Data Augmentation for Deep Learning. Journal of Big Data, 6(1), 60. https://doi.org/10.1186/s40537-019-0197-0 ↩

- Pan, S. J., & Yang, Q. (2010). A Survey on Transfer Learning. IEEE Transactions on Knowledge and Data Engineering, 22(10), 1345–59. https://doi.org/10.1109/TKDE.2009.191; Zoph, B., Ghiasi, G., Lin, T.-Y., Cui, Y., Liu, H., Cubuk, E. D., & Le, Q. V. (2020). Rethinking Pre-Training and Self-Training. arXiv.org. https://arxiv.org/abs/2006.06882v2 ↩

- Linardatos, P., Papastefanopoulos, V., & Kotsiantis, S. (2021). Explainable AI: A Review of Machine Learning Interpretability Methods. Entropy, 23(1), 18. https://doi.org/10.3390/e23010018; Longo, L., Brcic, M., Cabitza, F., Choi, J., Confalonieri, R., Del Ser, J., Guidotti, R., Hayashi, Y., Herrera, F., Holzinger, A., Jiang, R., Khosravi, H., Lecue, F., Magieri, G., Páez, A., Samek, W., Schneider, J., Speith, T., & Stumpf, S. (2024). Explainable Artificial Intelligence (XAI) 2.0: A Manifesto of Open Challenges and Interdisciplinary Research Directions. Information Fusion, 106, 102301. https://doi.org/10.1016/j.inffus.2024.102301; Lopes, P., Silva, E., Braga, C., Oliveira, T., & Rosado, L. (2022). XAI Systems Evaluation: A Review of Human and ComputerCentred Methods. Applied Sciences, 12(19), 9423. https://doi.org/10.3390/app12199423; Simonyan, K., Vedaldi, A., & Zisserman, A. (2014). Deep Inside Convolutional Networks: Visualising Image Classification Models and Saliency Maps. arXiv.org. https://doi.org/10.48550/arXiv.1312.6034 ↩

- Murphy, C., & Barr, J. (2023). Responsibly Harnessing the Power of AI. Consolidated Nuclear Security, LLC. https://www.osti.gov/biblio/2283006 ↩

- Bayer, S., Gimpel, H., & Markgraf, M. (2022). The Role of Domain Expertise in Trusting and Following Explainable AI Decision Support Systems. Journal of Decision Systems 32(1), 110–38. doi. https://doi.org/10.1080/12460125.2021.1958505 ↩